(Manuel García Doncel– Asesor de la Cátedra Ciencia, Tecnología y Religión de Comillas. Catedrático emérito de Física de partículas en la UAB. Antiguo profesor visitante del CERN) Es, ante todo, la máquina más grande y sofisticada que ha proyectado la humanidad, y constituye un símbolo de la llamada big science o ciencia pesada. Pretende hacer chocar frontalmente, a velocidades muy próximas a la de la luz, “hadrones” -es decir partículas subatómicas masivas-, de momento protones, o sea núcleos de hidrógeno (aunque se proyecta hacer después lo mismo con núcleos de plomo, 207 veces más masivos).

(Manuel García Doncel– Asesor de la Cátedra Ciencia, Tecnología y Religión de Comillas. Catedrático emérito de Física de partículas en la UAB. Antiguo profesor visitante del CERN) Es, ante todo, la máquina más grande y sofisticada que ha proyectado la humanidad, y constituye un símbolo de la llamada big science o ciencia pesada. Pretende hacer chocar frontalmente, a velocidades muy próximas a la de la luz, “hadrones” -es decir partículas subatómicas masivas-, de momento protones, o sea núcleos de hidrógeno (aunque se proyecta hacer después lo mismo con núcleos de plomo, 207 veces más masivos).

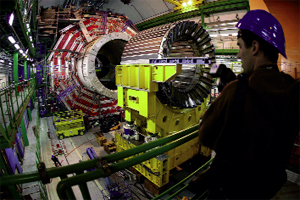

Esta máquina se ha montado en el CERN (Centro Europeo de Investigación Nuclear) de Ginebra, en un túnel anular de 27 km. de perímetro, excavado a unos 100 metros de profundidad en un apropiado terreno rocoso, que se extiende entre el Lago de Ginebra y el Jura. Por el eje central del túnel corre un delicado tubito anular, instalado a la décima de milímetro y con un vacío casi absoluto en su interior. Por él circularán paralelamente dos haces de protones, uno en el sentido de las agujas del reloj y el otro en sentido opuesto, casi a la velocidad de la luz, dando más de 11.000 vueltas por segundo (¡se comprende que no hayan de tropezar con moléculas de aire por el camino!). Los dos haces circulan normalmente paralelos como por las pistas de una simple carretera de doble sentido. Pero, en cuatro puntos a lo largo del circuito, se puede obligar a ambos haces a intercambiar sus pistas. En esos puntos, muchos pares de protones chocarán frontalmente, llevando cada uno una energía cinética de 7 TeV (es decir, 7.000 veces superior a la energía equivalente a su masa). Esa energía de colisión de 14 TeV ¡podrá transformarse en nuevas partículas y antipartículas, con velocidades menores y una masa total de 14.000 protones!

Los protones de ambos haces son acelerados y teledirigidos por miles de sofisticados y potentísimos electroimanes, que abrazan continuamente su tubito. Han de ser tan potentes que, si fueran electroimanes convencionales, los bobinados de cobre por los que habría de pasar una intensa corriente eléctrica no cabrían en el túnel de cinco metros. Se requieren, pues, bobinados de un material superconductor, pero este material ha de estar a una temperatura muy próxima al “cero absoluto” (273,15 grados bajo el cero de nuestros termómetros). Esto se consigue haciendo circular por los 27 km. del túnel una corriente de helio no sólo líquido, sino “superfluido” a 1,9 K (o sea, 1,9 grados sobre el cero absoluto). Esto supone la hazaña “criogenética” más seria de la historia, en la que ponen a prueba sus técnicas las empresas más importantes del mundo.

La máxima sofisticación física está en los cuatro detectores que envuelven los puntos de colisión y registrarán lo que se produzca en ellos. Algunos tienen el tamaño de un edificio de diez pisos y han sido introducidos en enormes cavernas excavadas en la roca. Aquí hemos de conformarnos con dar sus nombres: ATLAS, ALICE, CMS y LHCb.

¿Qué se pretende obtener con él, y qué peligros tiene?

El LHC es símbolo también de la más clásica “ciencia pura”. Se ha proyectado para enriquecer nuestro conocimiento científico sobre la constitución última de la materia. Se prevé que ese conocimiento tendrá enormes aplicaciones prácticas, pero no es fácil sospechar cuáles, y no son ellas las que dirigen este proyecto de investigación.

Los físicos teóricos del mundo subatómico dan por bueno (desde el Congreso Internacional de Tokio 1978) un “modelo estándar de partículas elementales”. Es una generalización de la teoría cuántica de la “interacción electromagnética” (responsable de todos los fenómenos eléctricos y magnéticos) a las dos nuevas interacciones descubiertas en el núcleo atómico: la “interacción (nuclear) fuerte” y la “interacción (nuclear) débil”. El LHC pretende básicamente seguir contrastando experimentalmente ese “modelo estándar” y rellenar sus lagunas.

Por ejemplo, una teoría importante incluida en ese modelo estándar es la “teoría electrodébil”, propuesta en 1967 por S. L. Glasgow, A. Salam y S. Weinberg. Es una preciosa construcción teórica que unifica las interacciones electromagnética y débil, y recibió el Nobel de Física de 1979, al ser corroborada por todas las experiencias entonces realizadas. Esta teoría maneja, junto al fotón (o cuanto de luz) transmisor de la interacción electromagnética, los “bosones intermediarios W y Z” trasmisores de la interacción débil. Y éstos fueron detectados en el CERN por C. Rubbia y S. Van der Meer en 1983, mediante una sofisticada experiencia que les mereció el Premio Nobel de 1984. La paradoja teórica, directamente confirmada por esa experiencia, es que, mientras el fotón tiene una masa estrictamente nula, los bosones W y Z tienen masas enormes, 80 y 90 veces la del protón. Esa enorme masa, prevista en la primitiva teoría electrodébil, era allí explicada por la acción sobre el W y el Z de un universal “campo de Higgs”, que mediante un complejo mecanismo les “da” esas masas. Según la teoría cuántica, a ese campo corresponde una partícula, ‘el bosón de Higgs’, que ha sido infructuosamente buscado en anteriores experiencias de colisión de más baja energía, y ahora se busca frenéticamente con la gran energía de colisión antes indicada. Así que está en juego: o tener que modificar el modelo estándar, si ‘el bosón de Higgs’ no existe, o, si existe, entender mediante ese ‘mecanismo de Higgs’ el misterio de las diversas masas de las partículas (y la cantidad de materia ordinaria u “oscura” del universo).

Evidentemente, aparte de las imprevisibles utilidades tecnológicas que esa física más básica nos depare, la epopeya de poner en funcionamiento el LHC ofrece una remuneración inmediata en transferencia internacional de tecnología. Las técnicas de construcción civil de precisión, de pequeños aceleradores con aplicaciones médicas (cáncer, diagnóstico por imagen PET…), de superconductividad, de criogenia, de transmisión de información (la WWW nació en el CERN para su colaboración internacional)… son automáticamente transferidas a las empresas que allí trabajan, normalmente de los países miembros.

El LHC no tiene peligros especiales, por ejemplo de radioactividad persistente, como tiene todo reactor de fisión. Así, la avería tonta detectada a los nueve días de su inauguración, el 19 de septiembre, por más que exija suprimir y volver a poner en marcha el sistema criogénico, retrasando en dos meses la obtención de los primeros datos experimentales, no ha supuesto en ningún momento peligro para el personal. Y la acusación al tribunal europeo de que no es nula la “probabilidad cuántica” de que el LHC formara un “agujero negro” en uno de los puntos de intersección, que con su enorme fuerza gravitacional podría tragarse el Cantón de Ginebra, la Tierra, el sistema solar y la Galaxia, no dejó de ser un juego ingenioso, por más que el juez impusiera una moratoria de un par de días a la inauguración.

¿Podrán estas experiencias explicar la creación del mundo?

Explicar la “creación”, desde luego no. Ése es un concepto filosófico-teológico que desborda las experiencias y teorías de las ciencias (por más que ese término sea trivializado por la teoría cuántica de campos, que maneja los “operadores de creación y aniquilación”).

Pero el LHC puede explicar aspectos importantes del “modelo estándar del Big Bang“, que hoy hemos de relacionar con el modo concreto en que Dios realiza la “creación continua”. Porque producir esas grandes energías de colisión concentradas en un punto es alcanzar en ese punto altísimas temperaturas, comparables a las que, según ese modelo, tenía el universo poco después del Big Bang. Y esto nos permite conocer algo de cómo era entonces el universo.